Les Secrets du Système de Classement de Google Révélés par une Déposition Judiciaire

Dans le cadre de la plainte du gouvernement américain contre Google, de nouveaux éléments fascinants ont été publiés, nous offrant un rare aperçu des mécanismes internes de classement du géant de la recherche. Après les révélations sur NavBoost, une déposition d'un ingénieur de Google, récemment rendue publique par le Département de Justice américain, nous dévoile des informations précieuses sur les scores de qualité des pages et confirme l'existence d'un mystérieux signal de popularité utilisant les données de Chrome. Plongeons ensemble dans ces révélations qui éclaircissent le fonctionnement de l'algorithme le plus influent du web.

Les Signaux "Fabriqués à la Main" de Google

Contrairement à ce que l'on pourrait penser, les signaux de Google sont "fabriqués à la main" (hand-crafted). Cela ne signifie pas que les sites sont classés manuellement, mais plutôt que les algorithmes sont soigneusement élaborés et ajustés par des ingénieurs. Ce processus implique l'analyse des données provenant des évaluateurs de qualité et des comportements des utilisateurs, puis l'application de formules mathématiques et statistiques pour générer un score de classement.

Cette approche se distingue nettement de celle de Microsoft Bing, plus automatisée. Selon le document, lorsqu'un problème survient chez Bing, le dépannage est bien plus complexe que chez Google, où la transparence interne des signaux permet aux ingénieurs d'identifier rapidement l'origine des dysfonctionnements.

Les Signaux ABC : Le Cœur de la Pertinence

La déposition révèle l'existence des "Signaux ABC", qui constituent les composants fondamentaux de la topicalité (ou score de base). Ces trois éléments essentiels sont :

- A – Anchors : Les ancres de texte des liens pointant vers les pages cibles

- B – Body : La présence des termes de recherche dans le contenu du document

- C – Clicks : Le temps passé par l'utilisateur sur la page avant de revenir aux résultats de recherche

Ces signaux sont au cœur de ce que Google appelle la "topicalité" (T*), qui détermine la pertinence d'un document par rapport à une requête spécifique. Cependant, il est important de comprendre que le classement des résultats de recherche est infiniment plus complexe et implique des centaines, voire des milliers d'algorithmes supplémentaires à chaque étape du processus, de l'indexation à l'analyse des liens, en passant par les processus anti-spam, la personnalisation et le reclassement.

Qualité de Page et Pertinence : Un Équilibre Délicat

Un point particulièrement intéressant révélé par l'ingénieur concerne la relation entre la qualité de page et la pertinence. La qualité d'une page est généralement statique et indépendante des requêtes. En d'autres termes, si une page est jugée de haute qualité et digne de confiance, elle sera considérée comme telle pour toutes les requêtes associées.

"La qualité est généralement statique à travers plusieurs requêtes et n'est pas liée à une requête spécifique."

Cependant, dans certains cas, le signal de qualité peut intégrer des informations provenant de la requête elle-même. Par exemple, un site peut contenir des informations de haute qualité mais générales, alors qu'une requête recherchant des informations très spécifiques ou techniques pourrait orienter l'utilisateur vers un site de qualité plus spécialisé.

Le score de qualité (Q*) est décrit comme "incroyablement important" et représente la notion de fiabilité d'un site. C'est également un aspect sur lequel les utilisateurs se plaignent le plus fréquemment.

L’IA Complique la Donne en Matière de Qualité

L'ingénieur de Google admet que les préoccupations liées à la qualité persistent et que l'intelligence artificielle aggrave la situation. Il déclare :

"De nos jours, les gens se plaignent encore de la qualité, et l'IA empire les choses."

Cette observation reflète les défis croissants auxquels Google est confronté pour maintenir la qualité des résultats de recherche dans un écosystème web de plus en plus saturé de contenus générés par l'IA.

eDeepRank : Comprendre les Classements basés sur les LLM

La déposition mentionne également un système appelé eDeepRank, un mécanisme basé sur les modèles de langage (LLM) qui utilise BERT et les transformers. L'ingénieur explique :

"Essentiellement, eDeepRank tente de prendre les signaux basés sur les LLM et de les décomposer en composants pour les rendre plus transparents."

Cette décomposition des signaux LLM en composants semble être une manière de rendre le processus de classement basé sur l'IA plus compréhensible pour les ingénieurs de recherche, leur permettant ainsi de comprendre pourquoi le modèle classe certains contenus d'une certaine façon.

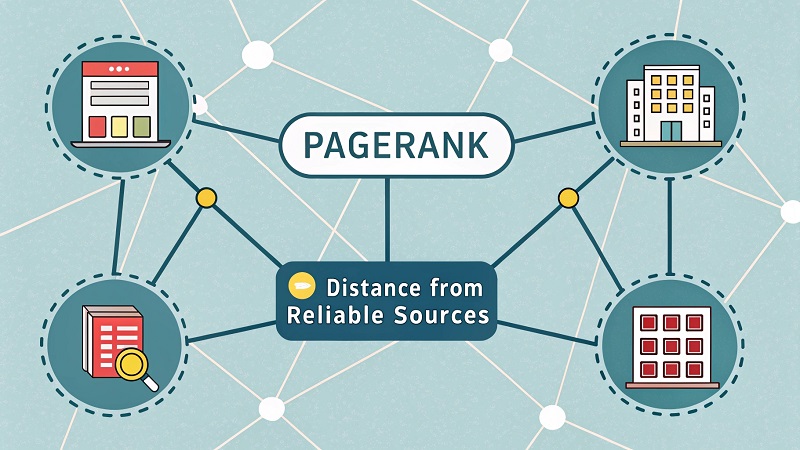

PageRank et les Algorithmes de Distance

Le fameux PageRank, l'innovation originale de Google en matière de classement, continue d'évoluer. Selon la déposition, PageRank est désormais décrit comme :

"Un signal unique lié à la distance depuis une source reconnue comme fiable, et il est utilisé comme donnée d'entrée pour le score de Qualité."

Cette description évoque les algorithmes de distance de liens qui calculent l'éloignement entre des sites autoritaires pour un sujet donné (appelés sites de référence) et d'autres sites dans le même domaine thématique. Ces algorithmes commencent par un ensemble de sites autoritaires de référence dans un sujet donné, et les sites qui sont plus éloignés de leur site de référence respectif sont considérés comme moins fiables. À l'inverse, les sites plus proches des ensembles de référence sont plus susceptibles d'être considérés comme autoritaires et dignes de confiance.

Le Mystérieux Signal de Popularité basé sur Chrome

L'un des aspects les plus intrigants de la déposition concerne un signal dont le nom a été censuré, mais qui est lié à la popularité et utilise les données de Chrome :

"[censuré] (popularité) signal qui utilise les données de Chrome."

Cette révélation pourrait confirmer les soupçons selon lesquels Google utilise effectivement les données de navigation collectées via Chrome comme facteurs de classement. Cependant, de nombreux experts SEO pensent que ces API sont simplement des outils destinés aux développeurs, utilisés par Chrome pour afficher des métriques de performance comme les Core Web Vitals dans l'interface des outils de développement.

Il est possible que ce signal de popularité soit quelque chose que nous ne connaissons pas encore complètement.

Un Aperçu Précieux mais Incomplet

L'ingénieur de Google mentionne également d'autres fuites de documents qui font référence à des "composants du système de classement de Google", mais précise qu'ils ne contiennent pas suffisamment d'informations pour permettre une rétro-ingénierie complète de l'algorithme.

Cette déposition nous offre donc une vue d'ensemble et très générale des signaux de classement, donnant une idée de ce que font les algorithmes sans en révéler les spécificités techniques. Elle confirme néanmoins plusieurs théories SEO de longue date et nous aide à mieux comprendre les principes fondamentaux qui guident l'algorithme de recherche le plus influent au monde.

Pour les professionnels du référencement et les propriétaires de sites, ces informations soulignent l'importance continue de créer du contenu de haute qualité, pertinent et digne de confiance, tout en construisant une autorité thématique solide. En fin de compte, comprendre ces mécanismes nous permet d'aligner nos stratégies SEO sur les objectifs fondamentaux de Google : fournir aux utilisateurs les réponses les plus pertinentes et fiables possible.

Sources : https://www.justice.gov/atr/us-and-plaintiff-states-v-google-llc-2020-remedies-hearing-exhibits