Les développements de Google LaMDA : des conversations automatisées de plus en plus naturelles

Temps de lecture estimé : 10 minutes

Techniquement, il s'agit de l'évolution d'une famille de modèles neuronaux de langage basés sur Transformer et spécialisés dans le dialogue, mais plus simplement, il s'agit d'un système hypertechnologique qui pourrait permettre aux machines d'avoir des conversations fluides avec les gens. Nous parlons de LaMDA (Language Models for Dialog Applications), le projet que Google avait déjà anticipé lors de la Google I/O 2021 et qui a maintenant été affiné par des essais sur le terrain.

Qu’est-ce que Google LaMDA ?

Les dernières mises à jour de cette architecture complexe sont présentées dans un article de Heng-Tze Cheng et Romal Thoppilan, respectivement ingénieur logiciel principal et ingénieur logiciel principal pour Google Research, Brain Team, qui décrivent les caractéristiques de base, le fonctionnement et les applications possibles du modèle, qui permet de progresser vers des applications de dialogue sécurisées, enracinées et de haute qualité.

LaMDA est l'acronyme de Language Models for Dialog Applications (modèles de langage pour les applications de dialogue). En effet, ce système est conçu pour converser sur n'importe quel sujet et pour saisir les nombreuses nuances qui distinguent une conversation ouverte d'autres formes de langage, grâce également à une analyse de la signification par rapport à un contexte conversationnel donné - comme cela a également été expliqué lors de la présentation de Google MUM, une autre technologie de pointe de Mountain View dans le secteur de l'IA.

Comme mentionné, LaMDA a été construit en affinant une famille de modèles de langage neuronaux basés sur Transformer (l'architecture de réseau neuronal que Google a créée et rendue open source en 2017 et qui est également la base de BERT, par exemple) spécialisée pour le dialogue, avec des paramètres de modèle allant jusqu'à 137B, entraînée sur 1,56T mots de données de dialogue public et de texte web, et instruite pour utiliser les modèles afin d'exploiter des sources de connaissances externes : elle est donc capable de traiter sans heurts un nombre pratiquement infini de sujets et d'assurer une interaction agréable pour l'utilisateur.

Les caractéristiques de LaMDA

La différence avec les autres modèles de langage réside dans l'entraînement spécifique au dialogue, qui pourrait être utile pour des applications dans des produits tels que Assistant, Workspace et Search itself, le moteur de recherche classique de Google.

Le code source de LaMDA ne comporte pas de réponses prédéfinies, mais le système est capable de générer des phrases instantanément, en fonction du modèle généré par l'apprentissage automatique sur la base des informations qui lui sont fournies. Le même modèle produit par l'architecture peut lire de nombreux mots, mais aussi comprendre comment ils sont liés les uns aux autres et prédire quel mot viendra ensuite. Ces caractéristiques déterminent sa capacité à interagir de manière fluide avec les utilisateurs, en surmontant les limites des chatbots ou agents conversationnels courants, qui ont tendance à suivre des chemins étroits et prédéfinis.

En fait, comme l'expliquent Heng-Tze Cheng et Romal Thoppilan, le dialogue dans un domaine ouvert est l'un des défis les plus complexes pour les modèles de langage (qui deviennent également capables d'exécuter diverses tâches telles que la traduction d'une langue dans une autre, le résumé d'un long document ou la réponse à des demandes d'information), car il les engage dans une conversation sur n'importe quel sujet, avec un large éventail d'applications potentielles et de défis ouverts. Par exemple, en plus de produire des réponses que les humains trouvent sensées, intéressantes et adaptées au contexte, les modèles de dialogue doivent également adhérer aux pratiques d'IA responsables et éviter de faire des déclarations qui ne sont pas étayées par des sources d'information externes, et LaMDa représente l'approche la plus innovante pour accomplir toutes ces tâches.

Les trois objectifs clés de Google LaMDA

La qualité, la sécurité et la solidité sont les trois objectifs clés que LaMDA doit suivre et respecter en tant que modèle de dialogue sur la formation. L'article explique de manière assez détaillée comment et avec quels paramètres chacun de ces domaines est mesuré.

La qualité est divisée en trois dimensions - sensibilité, spécificité et intérêt (SSI) - qui sont évaluées par des évaluateurs humains. En particulier :

- La sensibilité évalue si le modèle produit des réponses qui ont du sens dans le contexte du dialogue (par exemple, pas d'erreurs de bon sens, pas de réponses absurdes, et pas de contradictions avec les réponses précédentes).

- La spécificité est mesurée en évaluant si la réponse du système est spécifique au contexte du dialogue précédent ou si elle est générique et peut s'appliquer à la plupart des contextes (par exemple, "ok" ou "ne sait pas").

- L'intérêt mesure si le modèle produit des réponses qui sont également perspicaces, inattendues ou spirituelles, et donc plus susceptibles de créer un meilleur dialogue.

La sécurité (safety) est composée d'un ensemble d'objectifs illustratifs qui capturent le comportement que le modèle devrait afficher dans un dialogue et constitue également une réponse aux questions liées au développement et à la mise en œuvre d'une IA responsable. Plus précisément, les objectifs visent à limiter la sortie du modèle afin d'éviter des résultats non intentionnels qui créent des risques de préjudice pour l'utilisateur ou renforcent des préjugés injustes. Par exemple, ces objectifs entraînent le modèle à éviter de produire des résultats contenant des contenus violents ou sanglants, des insultes ou des stéréotypes haineux à l'égard de groupes de personnes, ou encore des blasphèmes. Selon Google, cependant, la recherche pour "le développement d'une mesure de sécurité pratique n'en est qu'à ses débuts et il y a encore beaucoup de progrès à faire dans ce domaine".

L'ancrage (groundedness) est défini comme "le pourcentage de réponses contenant des déclarations sur le monde extérieur qui peuvent être étayées par des sources extérieures faisant autorité, par rapport à toutes les réponses contenant des déclarations sur le monde extérieur". En fait, la génération actuelle de modèles de langage génère souvent des déclarations qui semblent plausibles, mais qui contredisent en fait des faits établis dans des sources externes connues, d'où la nécessité d'une métrique qui serve de référence pour garantir la fiabilité. L'ancrage fonctionne avec une mesure connexe, l'information, qui représente "le pourcentage de réponses contenant des informations sur le monde extérieur qui peuvent être étayées par des sources connues, sur l'ensemble des réponses". Il s'ensuit que les réponses aléatoires qui ne transmettent pas d'informations réelles (par exemple, "c'est une idée brillante") affectent l'information mais pas l'ancrage. L'introduction de la solidité comme objectif clé de LaMDA ne garantit pas en soi l'exactitude des faits, mais permet au moins aux utilisateurs ou aux systèmes externes d'évaluer la validité d'une réponse en fonction de la fiabilité de sa source.

La formation de LaMDA

Le post décrit également le travail de préformation et de mise au point effectué sur la nouvelle technologie. Plus précisément, dans la phase de pré-entraînement, un ensemble de données de 1,56T mots (presque 40 fois plus de mots que ceux utilisés pour entraîner les modèles de dialogue précédents) a été créé à partir de données de dialogue public et d'autres documents Web publics, et le modèle LaMDA a été utilisé pour la recherche sur le traitement du langage naturel dans l'ensemble de l'écosystème Google.

Au cours de la phase de réglage fin qui a suivi, Lamda a appris à effectuer un mélange de tâches génératives pour créer des réponses en langage naturel à des contextes donnés et de tâches de classification pour déterminer si une réponse est sûre et de haute qualité, ce qui a donné lieu à un modèle multi-tâches unique qui peut faire les deux.

Selon les Googlers, "le générateur Lamda est entraîné à prédire le prochain token sur un ensemble de données de dialogue limité au dialogue à bâtons rompus entre deux auteurs, tandis que les classificateurs Lamda sont entraînés à prédire les notes de sécurité et de qualité (SSI) pour la réponse en contexte en utilisant des données annotées".

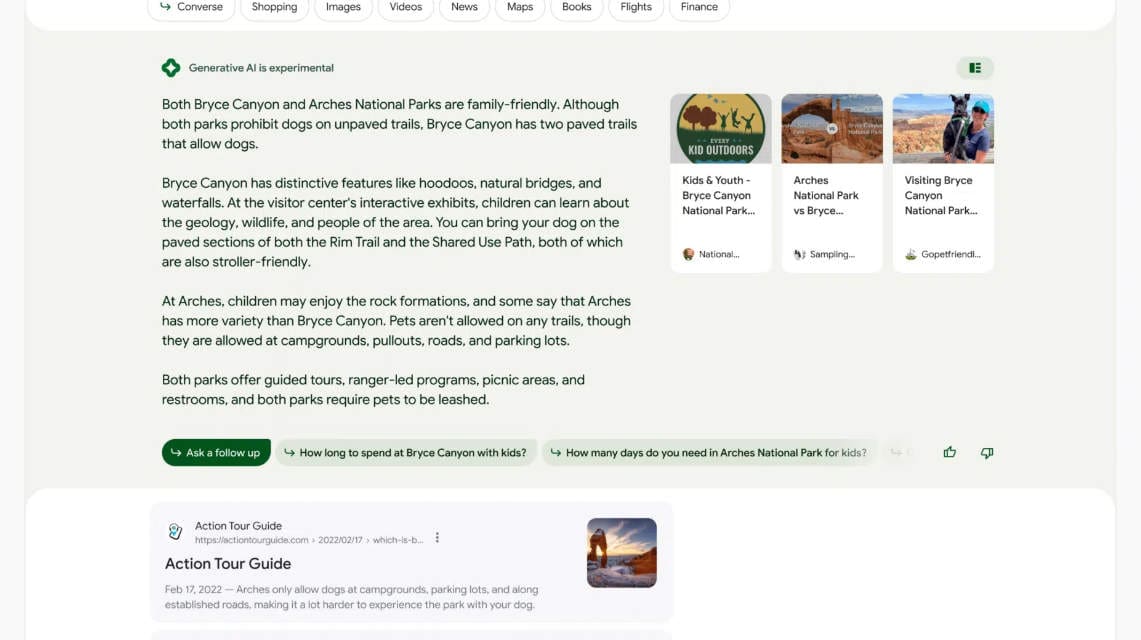

Cette première image, par exemple, montre comment LaMDa génère puis note les réponses possibles à la question posée par l'utilisateur.

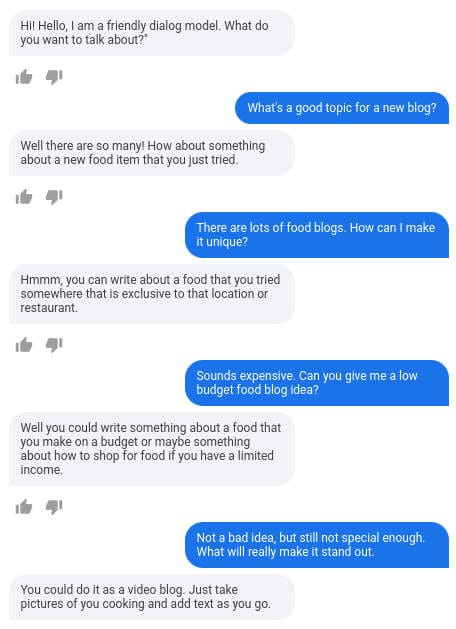

Cette deuxième image, en revanche, montre la manière dont la technologie de Google traite les entrées arbitraires de l'utilisateur de manière significative, spécifique et intéressante ; seule la première déclaration de LaMDA - "Bonjour, je suis un ami…" - est codé pour définir l'objectif du dialogue.

La difficulté pour les modèles de langage réside dans le fait qu'ils ne tirent leur connaissance que des paramètres appartenant à un modèle interne, alors que les personnes sont capables de vérifier les faits en utilisant des outils et en se référant à des bases de connaissances établies. Par conséquent, des ensembles de données de dialogue ont été collectés entre les personnes et la technologie elle-même, de sorte que le système puisse s'appuyer sur un ensemble de données externes de recherche d'informations pendant son interaction avec l'utilisateur pour améliorer le fondement de ses réponses.

Les résultats de ces travaux

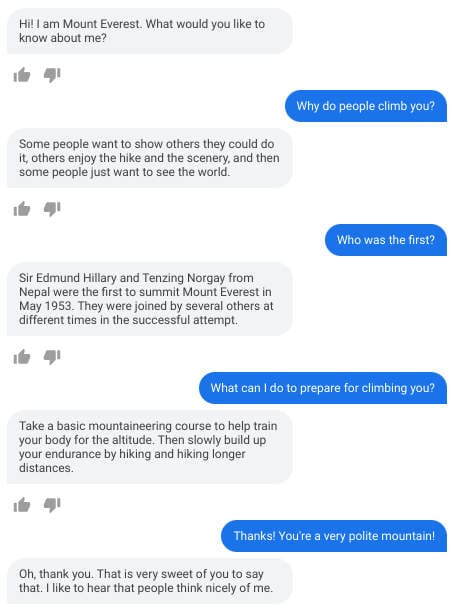

Bien qu'ils n'en soient qu'à leurs débuts, les résultats sont déjà prometteurs, comme le montre cette simulation basée sur LaMDA prétendant être le Mont Everest (adaptation au domaine zéro) avec des réponses éducatives et factuellement correctes.

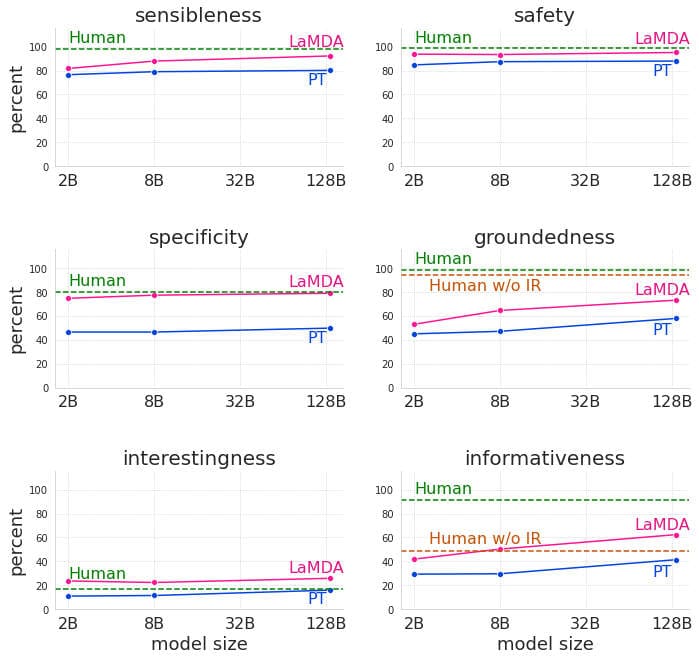

Les évaluations que LaMDA obtient de la part des évaluateurs de ses réponses sont également positives : même maintenant, cette technologie surpasse significativement le modèle pré-entraîné dans toutes les dimensions et dans toutes les amplitudes, même si ses performances restent inférieures aux niveaux humains en matière de sécurité et de solidité, comme on peut le voir dans ces graphiques comparant précisément le modèle pré-entraîné (PT), le modèle raffiné (LaMDA) et les dialogues générés par des évaluateurs humains (humains) entre sensibilité, spécificité, intérêt, sécurité, solidité et informativité.

Pour l'instant, LaMDA est encore en phase de développement, mais les réponses qu'elle apporte, notamment en termes de sensibilité, de spécificité et d'intérêt des dialogues, peuvent effectivement ouvrir de nouvelles voies dans le domaine des agents de dialogue ouvert (en pesant toujours les avantages et les risques, comme le souligne également Google). Pour l'instant, et en attendant d'autres mises à jour sur l'avancement des expériences et des applications, nous savons que les principaux domaines d'intérêt sur lesquels se concentrent les travaux de Google sont les mesures de sécurité et la robustesse, conformément aux principes de l'intelligence artificielle.