Crawl Budget : ce que c’est, ce que signifie le paramètre et comment l’optimiser pour le SEO

Il s'agit du paramètre qui identifie le temps et les ressources que Google entend consacrer à un site web par le biais des analyses de Googlebot, une valeur qui n'est pas unique et définissable numériquement, comme l'ont précisé à plusieurs reprises les sources officielles de la société, bien que nous puissions toujours intervenir pour l'optimiser. Nous parlons aujourd'hui du budget de crawl, un sujet qui devient de plus en plus central pour l'amélioration des performances des sites, et des différentes stratégies pour optimiser ce paramètre et perfectionner l'attention que le crawler peut consacrer aux contenus et aux pages qui sont prioritaires pour nous.

Quel est le budget de crawl ?

Google aime-t-il mon site web ? C'est la question que devrait se poser toute personne ayant un site web qu'elle souhaite positionner sur les moteurs de recherche. Il existe plusieurs méthodes pour savoir si Big G aime vraiment votre site, par exemple grâce aux données de la Google Search Console et au rapport Crawl Statistics, un outil qui nous permet de connaître les statistiques de crawl des 90 derniers jours et de savoir combien de temps le moteur de recherche passe sur notre site.

Pour faire encore plus simple, nous pouvons ainsi savoir quel budget de crawl Big G nous a alloué.

La définition du budget de crawl

Le budget de crawl est un paramètre, ou plutôt une valeur, que Google attribue à notre site. En pratique, il s'agit d'un budget dont Googlebot dispose pour analyser les pages de notre site. Grâce à la Search Console, il est possible de voir combien de fichiers, de pages et d'images sont téléchargés et analysés chaque jour par le moteur de recherche.

Il est facile de voir que plus cette valeur est élevée, plus nous sommes importants pour le moteur de recherche lui-même. En pratique, si Google scanne et télécharge autant de pages chaque jour, cela signifie qu'il veut notre contenu parce qu'il est considéré comme de qualité et de valeur pour la composition de ses SERPs.

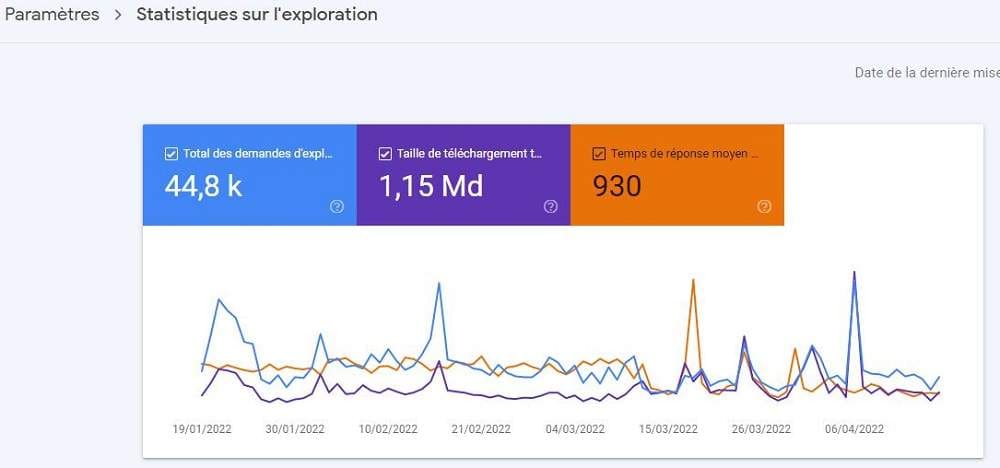

Capture d'écran des statistiques de crawl de la Search Console. Il y a deux valeurs principales à prendre en compte : le nombre de pages que Google crawle chaque jour et le temps que cela prend pour le faire. Voyons cela en détail :

- Pages explorées quotidiennement : la valeur idéale est d'avoir un nombre total de pages explorées supérieur au nombre de pages du site web, mais un nombre égal de pages explorées au nombre de pages du site web est plus que satisfaisant.

- Temps de téléchargement : il indique principalement le temps nécessaire à Googlebot pour analyser nos pages. Nous devons maintenir cette valeur basse en augmentant la vitesse de notre site Web. Cela aura également une incidence sur le nombre de ko téléchargés par le moteur de recherche lors des analyses, c'est-à-dire sur la facilité (et la rapidité) avec laquelle Google parvient à "télécharger" les pages d'un site web.

Les deux images publiées ici montrent également l'évolution de ce domaine : les valeurs qui, en 2016 (écran supérieur), signalaient une activité moyenne, sont désormais indicatrices d'une demande de faible intensité.

Quel est le budget de crawl pour Google ?

En changeant d'approche, le budget d'exploration est le nombre d'URL que Googlebot peut (en fonction de la vitesse du site) et veut (en fonction de la demande des utilisateurs) explorer. Conceptuellement, il s'agit donc de la fréquence équilibrée entre les tentatives de Googlebot de ne pas surcharger le serveur et le désir général de Google d'explorer le domaine.

Soigner cet aspect peut permettre d'augmenter la vitesse à laquelle les robots des moteurs de recherche visitent les pages du site ; plus la fréquence de ces passages est élevée, plus l'index détecte rapidement les mises à jour des pages. Par conséquent, une valeur d'optimisation du budget de crawl plus élevée peut potentiellement aider à maintenir le contenu populaire à jour et à empêcher le contenu plus ancien de devenir obsolète.

Comment est mesuré le budget du crawl

Le budget d'exploration peut être défini comme le nombre d'URL que Googlebot peut et veut explorer, et détermine le nombre de pages que les moteurs de recherche analysent au cours d'une session de recherche pour les indexer. En termes techniques, sa valeur dépend de la vitesse d'exploration et de la demande d'exploration.

Que sont le taux d'exploration et la demande d'exploration ?

L'expression "taux de balayage" fait référence au nombre de requêtes par seconde qu'une araignée effectue sur un site et au temps qui s'écoule entre deux balayages, tandis que la demande de balayage est la fréquence à laquelle ces robots balayent. Par conséquent, selon les conseils officiels de Google, les sites qui doivent faire plus attention à ces aspects sont ceux qui sont plus grands et ont plus de pages, ou ceux qui ont des pages générées automatiquement sur la base de paramètres d'URL.

Les limites du taux de crawl pour un site

En approfondissant les explications, la limite du taux d'exploration est d'abord donnée par le respect du site : Googlebot essaiera de ne jamais détériorer l'expérience de l'utilisateur en raison d'une surcharge de recherche. Ainsi, il existe pour chaque site un nombre maximal de connexions parallèles simultanées que Googlebot peut utiliser pour l'exploration, et le taux d'exploration peut augmenter ou diminuer en fonction de la santé (si un site répond rapidement, la limite augmente et Google utilise davantage de connexions pour l'exploration ; si l'exploration est lente ou si des erreurs de serveur se produisent, la limite diminue) et de la limite imposée dans Search Console.

La popularité et l'obsolescence déterminent la demande d'exploration de Google.

La demande de crawl, quant à elle, est liée à la popularité : les URL les plus populaires sur le Web ont tendance à être crawlées plus fréquemment afin de les garder plus "fraîches" dans l'index de Google. En outre, les systèmes des moteurs de recherche tentent d'éviter le staleness, c'est-à-dire que les URL deviennent obsolètes dans l'index.

Pourquoi le budget de crawl est important pour le référencement

Lorsqu'il est optimisé, le budget de crawl permet aux webmasters de donner la priorité aux pages qui doivent être crawlées et indexées en premier, dans le cas où les crawlers peuvent analyser chaque chemin. À l'inverse, gaspiller les ressources du serveur sur des pages qui ne génèrent pas de résultats et ne produisent pas réellement de valeur a un effet négatif et risque de priver un site de contenu de qualité.

Comment augmenter le budget "crawl" ?

Mais existe-t-il un moyen d'augmenter le budget de crawl que Google met lui-même à disposition ? La réponse est oui, et il suffit de quelques astuces.

L'une des façons d'augmenter le budget de crawl est certainement d'augmenter la confiance du site. Comme nous le savons tous, les liens sont l'un des facteurs de classement de Google : si un site est lié, cela signifie qu'il est "recommandé" et, par conséquent, le moteur de recherche interprète cela comme une recommandation et prend donc le contenu en considération.

Le budget de crawl est également influencé par la fréquence de mise à jour du site, c'est-à-dire la quantité de nouveau contenu créé et la fréquence. En pratique, si Google vient sur un site Web et découvre de nouvelles pages chaque jour, il réduira le temps nécessaire à l'exploration du site. Un exemple concret : généralement, un site d'information qui publie 30 articles par jour aura un temps d'exploration plus court qu'un blog qui publie un article par jour.

Une autre façon d'augmenter le budget de crawl est certainement la vitesse du site web, c'est-à-dire la réponse du serveur pour servir la page demandée à Googlebot. Enfin, nous pouvons également utiliser le fichier robots.txt pour empêcher Googlebot d'explorer les pages qui comportent une balise "noindex" ou "canonical", afin qu'il n'ait pas à les voir et à les explorer de toute façon pour savoir s'il peut les indexer ou non ; en utilisant intelligemment le fichier robots.txt, nous pouvons donc permettre au robot d'exploration de se concentrer sur les meilleures pages du site Web.

Comment améliorer le budget crawl

Plus généralement, l'une des façons les plus immédiates d'optimiser le budget d'exploration est de limiter la quantité d'URL de faible valeur sur un site Web, qui peuvent prendre un temps et des ressources précieux au détriment de l'exploration des pages les plus importantes d'un site.

Les pages de faible valeur comprennent celles qui contiennent du contenu dupliqué, des pages d'erreur logicielle, une navigation à facettes et des identifiants de session, ainsi que les pages compromises par le piratage, les espaces infinis et les proxies, et bien sûr le contenu de faible qualité et le spam. Un premier travail qui peut être fait est donc de vérifier ces problèmes sur le site, notamment en vérifiant les rapports d'erreurs de crawl dans Search Console et en minimisant les erreurs de serveur.

Optimisation du budget de crawl pour le SEO, meilleures pratiques

Un article approfondi d'Aleh Barysevich, publié sur Search Engine Land, présente une liste de conseils pour optimiser le budget d'exploration et améliorer la capacité d'exploration d'un site, avec 8 règles simples à suivre pour chaque site :

- Ne bloquez pas les pages importantes.

- Tenez-vous-en au HTML lorsque cela est possible, en évitant les fichiers JavaScript lourds ou d'autres formats.

- Résoudre de longues chaînes de réorientation.

- Signaler les paramètres des URL à Googlebot.

- Corriger les erreurs HTTP.

- Maintenez les sitemaps à jour.

- Utilisez la méthode rel canonical pour éviter le contenu dupliqué.

- Utilisez les balises hreflang pour indiquer le pays et la langue.

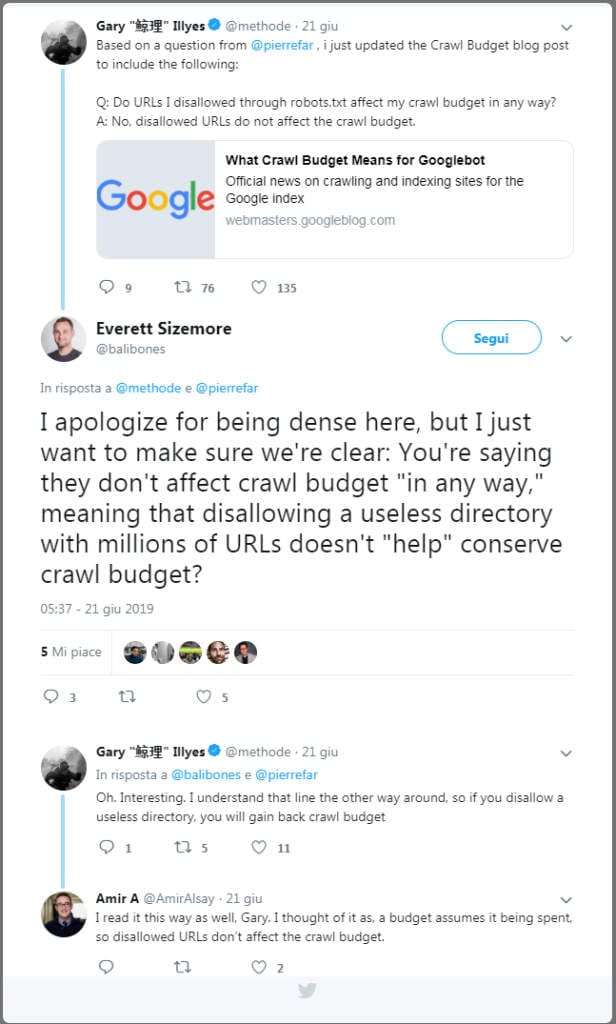

Un autre conseil technique pour optimiser le budget d'exploration d'un site nous vient de Gary Illyes, qui explique comment le fait d'activer la commande disallow sur les URL non pertinentes vous permet de ne pas grever le budget d'exploration, et donc d'utiliser la commande disallow dans le fichier robots peut vous permettre de mieux gérer l'exploration de Googlebot. Plus précisément, dans une conversation sur Twitter, le Googler a expliqué que "si vous interdisez un répertoire inutile contenant des millions d'URL, vous gagnez en budget d'exploration", car le robot consacrera son temps à l'analyse et à l'exploration de ressources plus utiles sur le site.

Mesures possibles d’optimisation du site

En approfondissant les conseils décrits ci-dessus, nous pouvons alors définir quelques interventions spécifiques qui pourraient aider à mieux gérer le budget de crawl du site : rien de particulièrement "nouveau", car il s'agit de signes bien connus de la santé d'un site Web.

La première suggestion est presque triviale, à savoir autoriser l'analyse des pages importantes du site dans le fichier robots.txt, une étape simple mais décisive pour avoir sous contrôle les ressources analysées et celles bloquées. De même, il est bon de soigner le plan du site XML, afin de donner aux robots un moyen facile et rapide de comprendre où mènent les liens internes ; n'oubliez pas d'utiliser uniquement les URL canoniques pour le plan du site et de toujours le mettre à jour à la version la plus récente chargée dans le fichier robots.txt.

Il serait également judicieux de vérifier - ou d'éviter complètement - les chaînes de redirection, qui obligent Googlebot à analyser plusieurs URL : en présence d'un quota excessif de redirections, le robot d'exploration du moteur de recherche peut soudainement mettre fin à l'analyse sans atteindre la page qu'il doit indexer. Si les 301 et 302 doivent être limités, d'autres codes d'état HTTP sont encore plus nuisibles : les pages 404 et 410 consomment techniquement des budgets de crawl et nuisent également à l'expérience utilisateur du site. Les erreurs 5xx liées au serveur ne sont pas moins ennuyeuses, c'est pourquoi il est bon d'effectuer une analyse périodique et un bilan de santé du site, peut-être en utilisant notre spider SEO !

Un autre point à prendre en compte est celui des paramètres de l'URL, car des URL distinctes sont comptées par les robots d'exploration comme des pages séparées, ce qui fait perdre une partie précieuse du budget et risque également de soulever des doutes quant au contenu dupliqué. Dans le cas de sites multilingues, il faut également utiliser au mieux la balise hreflang, en informant Google le plus clairement possible des versions géo-localisées des pages, tant avec l'en-tête qu'avec l'élément pour une URL donnée.

Enfin, un choix de base pour améliorer le crawling et simplifier l'interprétation de Googlebot pourrait être de toujours préférer le HTML aux autres langages : même si Google apprend à gérer JavaScript de plus en plus efficacement (et il existe de nombreuses techniques d'optimisation SEO de JavaScript), le vieux HTML reste le code qui donne les meilleures garanties.

Les problèmes critiques de référencement du budget de crawl

L'un des Googlers qui a le plus souvent abordé cette question est John Mueller qui, en particulier, a souligné sur Reddit qu'il n'y a pas de point de référence pour le budget crawl de Google, et qu'il n'y a donc pas de "nombre" de référence optimal à viser lors du travail sur le site.

Ce que nous pouvons faire, en termes pratiques, c'est essayer de réduire le gaspillage sur les pages "inutiles" de notre site - c'est-à-dire celles qui n'ont pas de mots-clés positionnés ou qui ne génèrent pas de visites - afin d'optimiser l'attention que Google consacre aux contenus qui sont importants pour nous et qui peuvent générer plus de trafic.

L'absence d'un point de référence ou d'une valeur idéale sur laquelle fonder toute la discussion sur le budget d'exploration repose sur des abstractions et des théories : ce dont nous sommes sûrs, c'est que Google est généralement plus lent à explorer toutes les pages d'un petit site qui n'est pas mis à jour souvent ou qui n'a pas beaucoup de trafic qu'un grand site avec de nombreuses modifications quotidiennes et un trafic organique important.

Le problème réside dans la quantification des valeurs de "souvent" et "très", mais surtout dans l'identification d'un nombre unique aussi bien pour les grands sites puissants que pour les petits blogs ; par exemple, toujours théoriquement, une valeur de X budget crawl atteint par un grand site web pourrait être problématique, alors que pour un blog avec quelques centaines de pages et quelques centaines de visiteurs par jour, il pourrait s'agir du niveau maximum atteint, difficile à améliorer.

Hiérarchisation des pages pertinentes

C'est pourquoi une analyse sérieuse de ce "budget de recherche d'indexation" devrait se concentrer sur la gestion globale du site, en essayant d'améliorer la fréquence des résultats sur les pages importantes (celles qui convertissent ou attirent du trafic) à l'aide de différentes stratégies, plutôt que d'essayer d'optimiser la fréquence globale de l'ensemble du site.

Les tactiques rapides pour y parvenir sont les redirections pour éloigner Googlebot des pages moins importantes (en les empêchant d'être explorées) et l'utilisation de liens internes pour canaliser plus d'importance vers les pages que vous voulez promouvoir (qui, ça va sans dire, doivent fournir un contenu de qualité). Si nous travaillons bien dans cette direction - en utilisant également les outils de Metadosi pour vérifier sur quelles URL il est préférable de se concentrer et de concentrer les ressources - nous pourrions augmenter la fréquence des visites de Googlebot sur le site, car Google devrait théoriquement voir plus de valeur dans l'envoi de trafic vers les pages qu'il indexe, met à jour et classe.

Comprendre si un site est apprécié par Google sans Search Console

Si nous n'avons pas accès à Search Console (par exemple, si nous ne possédons pas le site), il est toujours possible de savoir si le moteur de recherche apprécie le site avec certains outils. Nos allons identifier, les métriques natives qui identifie instantanément l'influence et la pertinence d'un site pour Google.

L'autorité prend en compte de nombreux critères, et pas seulement les pages figurant dans le top 10 de Google ou le nombre de liens obtenus. Une valeur élevée équivaut donc à une sympathie générale du moteur de recherche, qui récompense le contenu de ce site par une visibilité fréquente - et nous pouvons également analyser la pertinence par thème grâce à la métrique du Topical Trust Flow.

Plus précisément, chaque outil, Majestic, Ahref, ou MOZ cataloguent les pages web de chaque site projeté et les regroupent en fonction de leur performance dans les moteurs de recherche. Ainsi, nous savons clairement où intervenir, comment le faire et quand éliminer les pages inutiles ou dupliquées qui gaspillent le budget de crawl.

En pratique, cet outil nous donne une visualisation concise et immédiate des URLs qui consomment et gaspillent le plus de ressources du crawler, afin que nous puissions intervenir et rendre plus efficace la gestion du site dans son ensemble.

FAQ sur le budget de crawl

Qu'est-ce que le budget de crawl ?

Le budget de crawl est un concept utilisé en SEO (Search Engine Optimization) qui désigne les ressources que les moteurs de recherche, comme Google, allouent pour crawler (explorer) un site web. Ce budget détermine combien de pages du site le moteur de recherche peut et veut explorer sur une période donnée. Il est influencé par deux facteurs principaux :

La capacité de crawl : Cela réfère à la quantité de ressources que le moteur de recherche est prêt à dépenser pour crawler un site. Si un site est très grand ou se met à jour fréquemment, il pourrait nécessiter un budget de crawl plus important.

L'intérêt pour le crawl : Cela dépend de l'importance ou de la popularité du site. Les sites qui sont régulièrement mis à jour avec du contenu de qualité ou qui ont beaucoup de trafic entrant (backlinks) sont souvent jugés plus dignes d'un budget de crawl plus élevé.

L'optimisation du budget de crawl peut inclure l'amélioration de la vitesse du site, la réduction des erreurs de crawl, l'amélioration de la structure de navigation du site, et la gestion efficace des directives de robots (comme le fichier robots.txt), pour s'assurer que les moteurs de recherche utilisent leur budget de crawl de manière optimale pour indexer les pages les plus importantes.

Comment calculer le budget de crawl ?

Le budget de crawl est un concept utilisé en SEO (Search Engine Optimization) pour désigner la quantité de ressources que Googlebot (ou d'autres robots d'indexation de moteurs de recherche) alloue à l'exploration d'un site web. Calculer le budget de crawl de manière précise peut être complexe, mais voici quelques facteurs clés à prendre en compte et une méthode simple pour estimer ce budget :

Facteurs influençant le budget de crawl

Fréquence de mise à jour du contenu : Plus vous mettez souvent à jour votre site, plus les robots seront susceptibles de le visiter pour indexer les nouvelles modifications.

Nombre de pages : Les grands sites avec beaucoup de pages peuvent nécessiter un budget de crawl plus important.

Liens entrants : Les sites avec de nombreux liens entrants de qualité sont souvent visités plus fréquemment par les robots d'exploration.

Performance du site : Un temps de chargement rapide et une bonne optimisation technique peuvent augmenter le budget de crawl.

Erreurs d'exploration : Trop d'erreurs lors de l'exploration (comme les erreurs 404) peuvent réduire le budget de crawl.

Méthode simple pour estimer le budget de crawl

Pour estimer votre budget de crawl, vous pouvez utiliser les outils de webmaster comme Google Search Console. Voici une méthode basique pour l'estimer :

Accédez à la Google Search Console de votre site.

Consultez le rapport "Couverture" pour voir combien de pages sont indexées et les erreurs éventuelles.

Regardez le rapport "Statistiques d'exploration" pour voir combien de pages Googlebot explore en moyenne par jour.

Exemple de calcul :

Supposons que Googlebot visite votre site et explore en moyenne 100 pages par jour, et que votre site comporte 1 000 pages au total. Vous pouvez estimer que votre budget de crawl permet à Google de visiter chaque page de votre site environ tous les 10 jours (1000 pages / 100 pages par jour).

Optimisation du budget de crawl

Pour maximiser votre budget de crawl, considérez les actions suivantes :

Améliorez les performances du site : Réduisez le temps de chargement des pages.

Optimisez l'architecture du site : Assurez-vous que votre structure de site permet aux robots d'explorer et d'indexer efficacement les pages importantes.

Corrigez les erreurs d'exploration : Réduisez le nombre de pages qui retournent des erreurs 404 ou d'autres erreurs serveur.

Mise à jour régulière du contenu : Maintenez votre site dynamique avec des mises à jour régulières pour encourager les visites fréquentes des robots.

Ces étapes devraient vous aider à comprendre et à potentiellement augmenter votre budget de crawl.

Le budget de crawl est-il réel ?

Oui, le budget de crawl est un concept réel et important en SEO. Il fait référence à la quantité de ressources qu'un moteur de recherche, comme Google, alloue pour explorer (crawler) un site web donné. Voici quelques points clés à ce sujet :

Chaque site a un budget de crawl limité, déterminé par des facteurs tels que l'autorité du domaine, la structure du site, la vitesse de chargement des pages, etc.

Si un site a beaucoup de pages de faible qualité ou une structure mal optimisée, le moteur de recherche peut épuiser le budget avant d'avoir exploré tout le contenu important.

Un budget de crawl insuffisant peut empêcher l'indexation de pages de valeur et impacter négativement le référencement.

Optimiser le budget de crawl implique de s'assurer que les pages importantes sont facilement accessibles, d'éliminer le contenu de faible qualité, d'améliorer la vitesse du site, d'utiliser une architecture plate, etc.

Les fichiers robots.txt et les balises meta robots permettent aussi de contrôler le crawl en indiquant au moteur les URLs à explorer ou non.

En résumé, gérer efficacement le budget de crawl est essentiel pour s'assurer que les moteurs de recherche découvrent et indexent les pages clés d'un site. C'est un aspect technique important à prendre en compte dans une stratégie SEO globale.

Les redirections affectent-elles le budget de crawl ?

Oui, les redirections peuvent affecter le budget de crawl d'un site web. Le budget de crawl désigne la quantité de ressources que les moteurs de recherche, comme Google, sont prêts à allouer à l'exploration d'un site. Voici comment les redirections influencent ce budget :

Consommation des ressources : Chaque redirection que le moteur de recherche doit suivre consomme une partie du budget de crawl. Si une URL est redirigée vers une autre, le moteur doit suivre cette chaîne jusqu'à atteindre la destination finale, utilisant ainsi plus de ressources pour un seul URL.

Redirections multiples : Les chaînes de redirections, où plusieurs redirections se succèdent avant d'arriver à la page de destination, peuvent consommer un budget de crawl significatif. Cela est particulièrement problématique si les chaînes sont longues ou complexes.

Effet sur l'indexation : Si un moteur de recherche utilise une grande partie de son budget de crawl pour suivre des redirections, il peut ne pas avoir suffisamment de ressources pour explorer d'autres pages du site. Cela peut ralentir l'indexation de nouvelles pages ou la mise à jour des pages existantes.

Pour minimiser l'impact des redirections sur le budget de crawl, il est recommandé de :

Utiliser des redirections de manière judicieuse et éviter les chaînes de redirections inutilement longues.

Vérifier régulièrement les configurations de redirection pour s'assurer qu'elles sont toujours pertinentes et optimisées.

Privilégier des redirections directes (301) vers la page cible finale autant que possible.

Dernières considérations sur le budget de Crawl

En fin de compte, il devrait être clair que le contrôle du budget de crawl est très important, car il peut être une indication positive que Google aime nos pages, surtout si notre site est scanné tous les jours, plusieurs fois par jour.

Selon Illyes - auteur en 2017 d'un article approfondi sur le blog officiel de Google - le budget d'exploration ne devrait toutefois pas trop s'inquiéter si "les nouvelles pages ont tendance à être explorées le jour même de leur publication" ou "si un site compte moins de quelques milliers d'URL", car cela signifie généralement que l'exploration de Googlebot fonctionne efficacement.

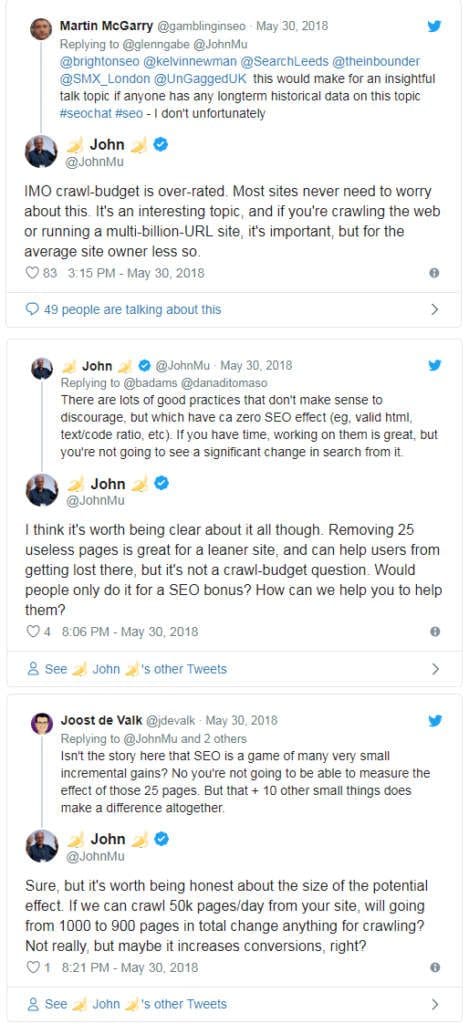

D'autres voix publiques chez Google ont également souvent exhorté les propriétaires de sites et les webmasters à ne pas trop s'inquiéter des budgets de crawl, ou plutôt à ne pas penser exclusivement aux aspects techniques absolus lors de l'optimisation onsite. Par exemple, dans un échange sur Twitter, John Mueller recommande de se concentrer d'abord sur les effets positifs de cette stratégie sur l'expérience utilisateur et l'augmentation des conversions.

Pour être précis, Search Advocat affirme qu'il existe de nombreuses bonnes pratiques pour optimiser le budget d'exploration, mais qu'elles peuvent avoir peu d'effets pratiques : par exemple, la suppression de 25 pages inutiles est un bon moyen d'alléger les sites et d'empêcher les utilisateurs de se perdre dans la navigation, mais ce n'est pas quelque chose à faire pour améliorer le budget d'exploration (question du budget d'exploration) ou pour espérer des gains de classement concrets.