Qu’est-ce que le fichier Robots.txt et comment l’implémentation de Robots.txt affecte-t-elle le référencement ?

Est-ce que le fichier robots.txt est l'épine dans votre pied SEO ?

Le référencement naturel inclut les changements de sites Web, petits et grands. Le fichier robots.txt peut sembler un élément SEO technique mineur, mais il peut avoir un impact considérable sur la visibilité et le classement de votre site.

Avec le fichier robots.txt expliqué, vous pouvez voir l'importance de ce fichier pour la fonctionnalité et la structure de votre site. Continuez à lire pour découvrir les meilleures pratiques de robots.txt pour améliorer votre classement dans la page de résultats des moteurs de recherche (SERP).

Vous voulez des services SEO efficaces d'une agence leader ? Metadosi dispose de services robustes et d'une équipe de consultants qui ajoutent leur expertise à votre campagne. Contactez-nous en ligne ou appelez-nous au 06 80 60 77 77 dès maintenant.

Qu’est-ce qu’un fichier robots.txt ?

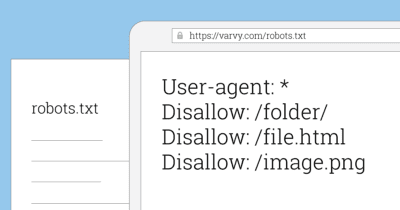

Un fichier robots.txt est une directive qui indique aux robots des moteurs de recherche ou aux robots crawlers comment procéder sur un site. Dans les processus de recherche et d'indexation, les directives agissent comme des ordres pour guider les robots des moteurs de recherche, comme Googlebot, vers les bonnes pages.

Les fichiers Robots.txt sont également catégorisés comme des fichiers texte, et ils vivent dans le répertoire racine des sites. Si votre domaine est "www.robotsrock.com", le fichier robots.txt est sur "www.robotsrock.com/robots.txt".

- Robots.txt a deux fonctions principales - ils peuvent autoriser ou interdire (bloquer) les robots. Cependant, le fichier robots.txt n'est pas la même chose que les méta directives noindex, qui empêchent les pages d'être indexées.

- Robots.txt comprend plus des suggestions que des règles inviolables pour les robots - et vos pages peuvent toujours finir indexées et dans les résultats de recherche pour certains mots-clés. Principalement, les fichiers contrôlent la charge sur votre serveur et gèrent la fréquence et la profondeur de l'exploration.

- Le fichier désigne les user-agents, qui s'appliquent soit à un robot de moteur de recherche spécifique, soit étendent l'ordre à tous les robots. Par exemple, si vous voulez juste que Google parcoure constamment les pages au lieu de Bing, vous pouvez leur envoyer une directive en tant qu'user-agent.

- Les développeurs ou propriétaires de sites Web peuvent empêcher les robots d'explorer certaines pages ou sections d'un site avec robots.txt.

Pourquoi utiliser les fichiers robots.txt ?

Vous voulez que Google et ses utilisateurs trouvent facilement des pages sur votre site Web - c'est tout l'intérêt du référencement, non ? Ce n'est pas forcément vrai. Vous voulez que Google et ses utilisateurs localisent sans effort les bonnes pages sur votre site.

Comme la plupart des sites, vous avez probablement des pages de remerciement qui suivent les conversions ou les transactions. Est-ce que les pages de remerciement doivent être référencées et classées et recevoir régulièrement la visite de crawler ? C'est peu probable.

L'exploration constante de pages non essentielles peut ralentir votre serveur et présenter d'autres problèmes qui entravent vos efforts de référencement. Le fichier Robots.txt est la solution pour modérer les robots qui crawler et quand.

Une des raisons pour lesquelles les fichiers robots.txt aident le référencement naturel est de traiter les nouvelles actions d'optimisation. Les crawlers enregistrent lorsque vous modifiez vos balises d'en-tête, vos méta descriptions et l'utilisation de vos mots-clés - et les moteurs de recherche efficaces classent votre site Web selon les développements positifs le plus rapidement possible.

Lorsque vous mettez en œuvre votre stratégie SEO ou publiez un nouveau contenu, vous voulez que les moteurs de recherche reconnaissent les modifications que vous apportez et que les résultats reflètent ces changements. Si vous avez un taux d'exploration du site lent, la preuve de l'amélioration de votre site peut prendre du retard.

Le fichier Robots.txt peut rendre votre site propre et efficace, bien qu'il ne pousse pas directement votre page plus haut dans les SERPs. Ils optimisent indirectement votre site, de sorte qu’il n’entraîne aucune pénalité, réduit votre budget d’exploration (Crawl Budget), ralentit votre serveur et insère les mauvaises pages pleines de liens.

Syntaxe des robots.txt

- User-Agent : le robot auquel s'applique la règle suivante (par exemple, «Googlebot», etc.)

- Disallow : les pages auxquelles vous souhaitez bloquer l'accès des bots (autant de lignes d'interdiction que nécessaire)

- Noindex : les pages que vous souhaitez qu'un moteur de recherche bloque ET non indexées (ou désindexées si elles ont déjà été indexées). Officiellement pris en charge par Google; non pris en charge par Yahoo et Live Search.

- Chaque groupe User-Agent / Disallow doit être séparé par une ligne vide; cependant, aucune ligne vierge ne doit exister dans un groupe (entre la ligne User-agent et le dernier Disallow).

- Le symbole de hachage (#) peut être utilisé pour les commentaires dans un fichier robots.txt, où tout ce qui suit # sur cette ligne sera ignoré. Peut être utilisé pour des lignes entières ou pour des fins de lignes.

- Les répertoires et les noms de fichiers sont sensibles à la casse : «privé», «privé» et «PRIVÉ» sont tous uniquement différents des moteurs de recherche.

Examinons un exemple de fichier robots.txt. L'exemple ci-dessous comprend :

- Le robot appelé "Googlebot" n'a rien d'interdit et peut aller n'importe où

- L'ensemble du site est fermé au robot appelé «msnbot»;

- Tous les robots (autres que Googlebot) ne doivent pas visiter le répertoire / tmp / ou les répertoires ou fichiers appelés / logs, comme expliqué avec des commentaires, par exemple, tmp.htm, / logs ou logs.php.

User-agent: Googlebot

Disallow:

User-agent: msnbot

Disallow: /

Block all robots from tmp and logs directories

User-agent: *

Disallow: /tmp/

Disallow: /logs # for directories and files called logs

4 façons dont les fichiers robots.txt améliorent le référencement naturel

Bien que l'utilisation de fichiers robots.txt ne garantisse pas les meilleurs classements, elle est importante pour le référencement naturel. Il s'agit d'un composant SEO technique intégral qui permet à votre site de fonctionner en douceur et de satisfaire les visiteurs.

Le référencement naturel vise à charger rapidement votre page pour les utilisateurs, à fournir un contenu original et à dynamiser vos pages les plus pertinentes. Robots.txt joue un rôle en rendant votre site accessible et utile.

Voici quatre façons d'améliorer le référencement naturel avec les fichiers robots.txt.

1. Préservez votre Crawl budget

L'exploration des robots des moteurs de recherche est précieuse, mais l'exploration peut submerger les sites qui n'ont pas les moyens de gérer les visites des robots et des utilisateurs.

Googlebot prévoit un certain temps de crawl pour chaque site qui correspond à leurs désirs et à leur nature. Certains sites sont plus grands, d'autres détiennent une immense autorité, donc ils reçoivent une plus grande allocation de crawl Budget de Googlebot.

La demande d’exploration correspond au nombre de recherches que Google souhaite effectuer sur vos pages. Cela dépend de la popularité de vos pages et de l’ancienneté du contenu de l’index Google. Le Crawl Budget consiste à «combiner le taux d’exploration et la demande d’exploration». Google définit le budget de Crawl comme étant le «nombre d’URL que Googlebot peut et souhaite analyser».

Google ne définit pas clairement le Crawl Budget, mais ils disent que l'objectif est de prioriser ce qu'il faut explorer, quand il faut le faire et avec quelle rigueur.

Essentiellement, le "Crawl Budget" est le nombre de pages que Googlebot parcourt et indexe sur un site dans un certain laps de temps.

Le Crawl budget a deux facteurs déterminants :

- La limite de vitesse d'exploration impose une restriction sur le comportement d'exploration du moteur de recherche, de sorte qu'il ne surcharge pas votre serveur.

- La demande de crawl, la popularité et la fraîcheur déterminent si le site a besoin d'être plus ou moins exploré.

Comme vous ne disposez pas d’un nombre illimité d’exploration, vous pouvez installer le fichier robots.txt pour éviter à Googlebot des pages supplémentaires et les diriger vers les pages les plus importantes. Cela élimine le gaspillage de votre budget d'exploration et vous évite, ainsi qu'à Google, de vous soucier des pages non pertinentes.

2. Empêcher les doublons de contenu

Les moteurs de recherche ont tendance à froncer les sourcils sur le contenu en double. Bien qu'ils ne veuillent pas de contenu dupliqué. Le contenu dupliqué comme les versions PDF ou les versions imprimables de vos pages ne pénalise pas votre site.

Cependant, vous n'avez pas besoin que les robots parcourent les pages de contenu en double et les afficher dans les SERPs. Le fichier Robots.txt est l'une des options permettant de réduire au minimum le duplicate content disponible pour le crawl.

Il existe d'autres méthodes pour informer Google sur le contenu dupliqué comme la canonicalisation - ce qui est la recommandation de Google - mais vous pouvez également ajouter des fichiers robots.txt pour conserver votre budget de crawl.

3. Passer l'équité des liens vers les bonnes pages

L'équité des liens internes est un outil spécial pour augmenter votre référencement naturel. Vos pages les plus performantes peuvent rehausser la crédibilité de vos pages médiocres et moyennes aux yeux de Google.

Cependant, les fichiers robots.txt indiquent aux robots de faire un petit tour une fois qu'ils ont atteint une page avec la directive. Cela signifie qu'ils ne suivent pas les chemins liés ou n'attribuent pas le pouvoir de classement de ces pages s'ils obéissent à votre ordre.

Votre jus de lien (Link Juce) est puissant, et lorsque vous utilisez robots.txt correctement, l'équité du lien passe aux pages que vous voulez réellement élever plutôt que celles qui devraient rester en arrière-plan. N'utilisez les fichiers robots.txt que pour les pages qui n'ont pas besoin de l'équité de leurs liens sur la page.

4. Désigner des instructions de crawl pour les robots choisis

Même au sein d'un même moteur de recherche, il existe une variété de robots. Google a des crawlers en dehors du "Googlebot" principal, y compris Googlebot Images, Googlebot Vidéos, AdsBot, et plus encore.

Vous pouvez éloigner les robots d'exploration des fichiers que vous ne voulez pas voir apparaître dans les recherches avec robots.txt. Par exemple, si vous voulez empêcher les fichiers d'apparaître dans les recherches Google Images, vous pouvez mettre des directives d'interdiction sur vos fichiers images.

Dans les répertoires personnels, cela peut dissuader les robots des moteurs de recherche, mais n'oubliez pas que cela ne protège pas les informations sensibles et privées.

Collaborez avec Metadosi pour tirer le meilleur parti de votre fichier robots.txt

Les meilleures pratiques du fichier Robots.txt peuvent s'ajouter à votre stratégie de référencement naturel et aider les robots des moteurs de recherche à naviguer sur votre site. Avec des techniques SEO comme celles-ci, vous pouvez affiner votre site Web pour travailler à son meilleur et sécurisé un top classements dans les résultats de recherche.

Metadosi est une agence SEO de premier plan avec une équipe de consultants apportant leur expertise à votre campagne. Nos services de référencement naturel sont centrés sur les résultats, il est clair que nous allons de l'avant.

Intéressé à obtenir la plus haute qualité de services SEO pour votre entreprise ? Contactez-nous en ligne ou appelez-nous au 06 80 60 77 77 pour parler à un membre qualifié de notre équipe.