🔍 Augmentez votre indexabilité avec une gestion efficace de la profondeur de crawl pour un SEO performant 🔍

La gestion de la profondeur de crawl peut avoir un impact considérable sur les performances de votre site et vos classements dans les moteurs de recherche.

L'un des aspects souvent négligés de la gestion d'un site web est la gestion de la profondeur de crawl, c'est-à-dire le niveau auquel les bots des moteurs de recherche explorent et indexent les pages d'un site.

Comprendre comment contrôler et optimiser la profondeur de crawl peut avoir un impact significatif sur les performances de votre site et vos classements dans les moteurs de recherche.

Cet article vous fournira des conseils précieux et des actions concrètes en matière de SEO pour optimiser efficacement la profondeur de crawl.

La profondeur de crawl : qu’est-ce que c’est et pourquoi est-ce important ?

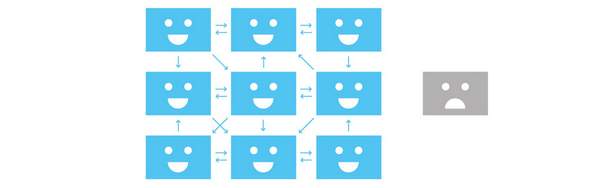

La profondeur de crawl fait référence au niveau ou à la distance d'une page web dans l'architecture d'un site à partir du point de départ ou de la racine.

Elle indique le nombre de clics ou d'étapes nécessaires pour qu'un crawler de moteur de recherche atteigne une page spécifique à partir de la page d'accueil ou de tout autre point de départ.

La profondeur de crawl d'une page est déterminée par le nombre de liens nécessaires pour naviguer de la page d'accueil à cette page particulière.

Par exemple, une page accessible directement depuis la page d'accueil sans aucun clic intermédiaire est considérée comme ayant une profondeur de crawl faible.

En revanche, une page nécessitant plusieurs clics ou le passage par plusieurs pages intermédiaires est considérée comme ayant une profondeur de crawl plus élevée.

La profondeur de crawl d'une page est importante car elle affecte la manière dont les bots des moteurs de recherche découvrent et indexent le contenu web. C'est là qu'intervient le très important Crawl Budget.

Les pages avec une profondeur de crawl faible sont plus facilement et plus fréquemment explorées par les bots des moteurs de recherche, ce qui permet une indexation plus rapide et une meilleure visibilité dans les résultats de recherche.

Inversement, les pages avec une profondeur de crawl plus élevée peuvent subir un crawl retardé ou limité, ce qui peut affecter leur visibilité et leur classement dans les résultats des moteurs de recherche.

Il est important de noter que la profondeur de crawl n'est pas la même chose que la profondeur d'une structure de site web ou la profondeur d'une URL.

La profondeur de crawl fait spécifiquement référence à la distance d'une page par rapport au point de départ en termes de clics ou de liens nécessaires pour l'atteindre lors du processus de crawl.

En comparaison, la profondeur d'un site web désigne la structure hiérarchique et l'organisation du contenu au sein d'un site. Elle représente les niveaux de pages ou de sections qu'un utilisateur doit parcourir pour accéder à un contenu spécifique.

Pourquoi devriez-vous gérer la profondeur de crawl ?

🔍 Une indexation et une visibilité améliorées 🔍

Veillez à ce que les pages importantes aient une profondeur de crawl faible pour augmenter les chances qu'elles soient découvertes et incluses dans les index des moteurs de recherche.

Une profondeur de crawl faible permet aux bots des moteurs de recherche de parcourir efficacement un site web, d'indexer les pages et de les rendre visibles aux visiteurs potentiels.

🚀 Une meilleure expérience utilisateur et une navigation facilitée 🚀

Une profondeur de crawl faible favorise une expérience conviviale, permettant aux visiteurs de trouver rapidement un contenu pertinent.

Une navigation facile améliore l'engagement des utilisateurs et réduit le risque d'abandon du site en raison de difficultés à trouver les informations recherchées.

✅ Comment influencer la profondeur de crawl ?

L'optimisation de la profondeur de crawl consiste à veiller à ce que les pages importantes, telles que le contenu de base ou les pages d'atterrissage prioritaires, aient une profondeur de crawl faible.

Cela peut être accompli grâce aux actions suivantes :

1️⃣ Rationalisez votre structure de liens internes

L'organisation et la hiérarchie des liens internes ont un impact significatif sur la profondeur de crawl.

Une structure de liens internes bien structurée, avec des chemins de navigation clairs et logiques, peut réduire la profondeur de crawl et aider les bots des moteurs de recherche à découvrir et indexer les pages plus efficacement.

Vous pouvez améliorer l'efficacité du crawl en créant des liens pertinents entre les pages et en créant une hiérarchie logique.

Répartissez les liens internes sur l'ensemble de votre site web pour que toutes les pages reçoivent une équité de liens suffisante.

Évitez les situations où certaines pages sont isolées ou reçoivent peu de liens internes, ce qui entrave leur découverte et leur indexation.

2️⃣ Donnez la priorité aux pages importantes

Les pages considérées comme importantes, telles que la page d'accueil, le contenu de base ou le contenu fréquemment mis à jour, doivent avoir une profondeur de crawl faible.

Cela garantit que les bots des moteurs de recherche peuvent accéder facilement et indexer ces pages cruciales.

3️⃣ Tenez compte de la taille et de la complexité de votre site web

Les sites web plus grands avec une hiérarchie complexe peuvent naturellement avoir une profondeur de crawl plus élevée.

Il est important de trouver un équilibre entre l'organisation efficace du contenu et la réduction de la profondeur de crawl pour les pages essentielles.

4️⃣ Mettez en place des sitemaps XML

L'utilisation de sitemaps XML peut aider les moteurs de recherche à comprendre la structure et la hiérarchie d'un site web.

Inclure les pages importantes dans le sitemap peut augmenter leur visibilité pour les bots des moteurs de recherche.

5️⃣ Optimisez la structure de vos URL

Une structure d'URL bien optimisée peut contribuer à un processus de crawl plus efficace.

Des URL claires et descriptives qui reflètent le contenu et la hiérarchie d'une page peuvent aider les bots des moteurs de recherche à comprendre la structure du site web.

6️⃣ Réparez les liens cassés

Vérifiez régulièrement les liens cassés et réparez-les rapidement.

Les liens cassés peuvent entraver le crawl efficace de votre site web par les bots des moteurs de recherche, ce qui entraîne une indexation incomplète.

7️⃣ Améliorez la vitesse de votre site web

Un site web qui se charge rapidement améliore l'expérience utilisateur et l'efficacité du crawl.

Découvrez d'autres astuces pour rendre votre site web plus rapide dans "La vitesse de chargement de page est-elle un critère de classement".

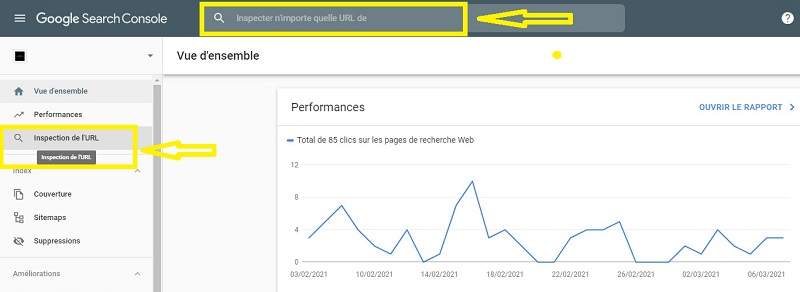

8️⃣ Suivez et résolvez les erreurs de crawl

Utilisez Google Search Console pour surveiller les erreurs de crawl. Enquêtez et résolvez ces erreurs en réparant les liens cassés, en redirigeant les pages ou en résolvant les problèmes de serveur.

- En minimisant la profondeur de crawl pour les pages web cruciales

- En suivant les conseils ci-dessus, vous pouvez améliorer la façon dont les moteurs de recherche parcourent votre site web et augmenter la visibilité de votre contenu.

- En contribuant à rendre le processus de crawl plus efficace, vous augmentez les chances que vos pages web soient indexées et apparaissent dans les résultats de recherche.

N'hésitez pas à partager vos expériences et vos astuces sur la gestion de la profondeur de crawl dans les commentaires ci-dessous ! 📝